A continuación, compartimos con todos Uds. un resumen de las novedades más destacadas del mundo de la ciencia y la tecnología.

Fresco y Batata, los primeros nanosatélites comerciales argentinos

Por Nora Bär

Si todo funcionó de acuerdo con lo previsto, media hora después de la medianoche de Buenos Aires, dos paralelepípedos de apenas 80 cm de alto, 40 de ancho y 40 de profundidad se convirtieron en los primeros nanosatélites argentinos en surcar el espacio completamente funcionales y aptos para ofrecer servicios comerciales.

A un costo mil veces menor que los que desarrollan las agencias espaciales estatales, Fresco y Batata, como los llamaron sus creadores, en alusión al típico postre local, coronan el ciclo de desarrollo de la joven compañía tecnológica Satellogic, creada por Emiliano Kargieman con apoyo del Ministerio de Ciencia, Tecnología e Innovación Productiva y del Invap.

Los precedieron tres aparatos de ensayo puestos en órbita en dos años: Capitán Beto, el 26 de abril de 2013; Manolito, el 21 de noviembre de ese mismo año, y Tita (por la inolvidable morocha argentina), el 20 de junio de 2014.

"En los tres primeros probamos la tecnología -cuenta Kargieman, ansioso por el inminente lanzamiento y la puesta en marcha operativa de la compañía-. Con estos dos ya podemos ofrecer servicios."

Fresco y Batata transportan tres cámaras de un metro de resolución: una multiespectral, otra hiperespectral y otra térmica. La multiespectral toma imágenes en rojo, verde, azul e infrarrojo cercano. "Es particularmente útil para aplicaciones en agricultura, porque permite conocer distintos parámetros biofísicos de los cultivos", explica.

"La hiperespectral saca fotos en 600 bandas y ofrece información, por ejemplo sobre composición química de los vertidos de una fábrica, variedades específicas de ciertos cultivos, absorción de clorofila y otros aspectos, como la evapotranspiración", agrega.

La cámara térmica obtiene imágenes en el infrarrojo. "No predomina lo que se refleja de la radiación solar, sino la radiación de cuerpo negro, que es tanto más intensa cuanto más elevada es la temperatura del emisor -continúa-. Con ésta incluso podemos detectar variaciones de centésimas de grado, «ver» la humedad de los suelos, saber cuánto petróleo hay en un barco o determinar la eficiencia energética de un edificio. Son datos que sirven para tomar decisiones de distinto tipo. Pero como nuestros satélites son miles de veces más económicos, nos permiten distribuirlos a un costo mucho menor."

Satellogic ya firmó cartas de intención con 10 clientes que comprarán estos servicios para monitoreo diario de campos y cultivos, y de infraestructura crítica para gobiernos. También, para control de seguridad en la industria petrolera y en el medio ambiente. Otras 45 compañías, en el país y en el mundo, se aprestan a recibirlos una vez que ambos satélites estén activos.

Los aparatos pesan unos 35 kg (10 más que Tita) y se desplazarán uno detrás del otro a lo largo de una órbita polar (es decir, que rodean la Tierra pasando por los polos) a 500 km de altura. Completan una vuelta cada 93 minutos.

"El tiempo de desarrollo de estos satélites fue de un año -detalla-, aunque, por supuesto, estamos avanzando de manera incremental sobre todo lo que veníamos haciendo con los satélites anteriores. Y si bien hay empresas en otros países que están yendo en busca de la misma oportunidad, en este momento vamos a estar liderando este campo en términos de satélites de alta resolución, con un margen 100 veces mejor en eficiencia y costos."

Democratizar el espacio

La fascinación de Emiliano Kargieman con la tecnología empezó muy temprano. Tenía ocho años cuando "se metió" en la Commodore 64 que había recibido de regalo para que ésta le diera más "vidas" en un juego de invasiones extraterrestres.

A los 15, armó su primera empresa con compañeros del secundario para hacer software destinado a pequeños negocios que estaban empezando a utilizar computadoras personales para llevar la contabilidad. A los 17, lo contrataron en la AFIP dentro de un grupo que hacía investigación en seguridad. Y a los 19, mientras estudiaba matemática en la Facultad de Ciencias Exactas y Naturales de la UBA, fundó Core Security, una compañía de seguridad informática que desarrolló el primer producto para hacerpenetration testing, un programa que emula lo que haría un atacante y después genera un reporte de cuál fue el camino de entrada.

Core fue la primera empresa del mundo que logró automatizar este proceso, que se suponía que no era automatizable. Hoy es una multinacional con base en Boston, tiene entre el 5 y el 8% de las patentes argentinas en los Estados Unidos y cuenta entre sus clientes al 80% de las compañías que figuran en el ranking Fortune 500.

Pero en 2006 abandonó esa compañía exitosa para crear una de inversiones de riesgo, Aconcagua Ventures. Mientras estaba impulsando este nuevo emprendimiento, se dio cuenta de que en realidad lo que le gustaba era "hacer cosas".

Tras algunas semanas en la Singularity University, un proyecto de los futurólogos Ray Kurzweil y Peter Diamandis que invita a emprendedores para que planteen un proyecto que permita mejorar la vida de 1000 millones de personas, se dio cuenta de que se podía revolucionar la industria del espacio reviviendo el romanticismo de las primeras épocas de la computación.

"Me di cuenta de que la industria del espacio usa ingeniería de hace cincuenta años, es terriblemente renuente al riesgo y está dominada por pocos jugadores muy grandes, que en general son proveedores del Estado. Eso resta incentivos para hacer las cosas en forma más eficiente, más rápida, más económica y mejor."

De esa convicción surgió Satellogic, una audaz aventura para democratizar la tecnología espacial y ponerla al alcance de pequeñas empresas, laboratorios, estudiantes, amateurs.

Con sabor local

El 26 de abril de 2013 presentó su primer "retoño", Capitán Beto, lanzado a bordo de un cohete chino. Era un cubo de 20 cm por 10 cm por 10 cm, de sólo dos kilos y medio de peso, que giró a 450 km de altura por sobre la superficie terrestre y se armó con materiales de ferretería y de teléfonos celulares. Un grano de arena en el océano cósmico, pero que permitió hacer una prueba de concepto concluyente.

Unos meses más tarde, desde la base rusa de Yasni, puso en órbita Manolito, de similares proporciones, diseñado y ensamblado en un ph de Colegiales.

En 2014 despegó Tita, que ya pesó 25 kilos y estaba preparado para jugar en primera. Aunque también fue un prototipo, y se produjo con las mismas estrategias de diseño y fabricación con componentes de uso comercial (resortes de ferretería, electrónica de teléfonos celulares y computadoras personales), permitió tomar imágenes y videos de dos metros de resolución, más o menos lo mismo que hace un satélite tradicional.

En estos tres años, Satellogic creció y hoy emplea a 63 personas que trabajan en seis países. Son físicos, ingenieros y especialistas en ciencias de la computación cuyo promedio de edad ronda los treinta años. "La mayor parte está en la Argentina, donde hacemos investigación y desarrollo -detalla el emprendedor-. La planta de integración la tenemos en Uruguay; en Israel tenemos un equipo de desarrollo de software; en Palo Alto, Estados Unidos, el desarrollo de negocios, y equipos de venta en Colombia, Canadá e Israel."

Todos los nanosatélites se diseñaron con tecnología totalmente made in Argentina y sin emplear dispositivos espaciales, solamente electrónica de consumo.

Los datos que envíen se recibirán en una estación terrena de la Argentina, diseñada y operada por los científicos e ingenieros de la compañía, y otra en Svalbaard, Noruega, cerca del Polo Norte.

Kargieman pronostica cielos despejados para el negocio satelital. Gigantes como Google y Facebook ya ingresaron en el mercado de los satélites pequeños y se espera que crezca velozmente en los próximos años.

Satellogic picó en punta. En noviembre lanzará otro pequeño satélite y dos más en marzo próximo. Los seis conformarán la constelación Aleph, como el cuento de Borges. "Un poco de nerviosismo es inevitable -confiesa-. Queremos que los datos espaciales estén al alcance de la mano. Estamos contentos y con ganas de empezar a operarlos, ofrecer datos satelitales y sentir el «tirón» de una compañía que empieza a estar impulsada por las necesidades de los clientes."

Fuente: La Nación

El universo se expande entre 5 y 9% más rápido de lo que se creía

Un grupo de astrónomos, con ayuda del telescopio espacial Hubble de la NASA, han descubierto que el universo se expande entre un 5 y un 9 por ciento más rápido de lo esperado.

"Este sorprendente hallazgo puede ser una pista importante para la comprensión de esas partes misteriosas del universo que conforman el 95 por ciento del mismo y que no emiten luz, como la energía oscura, la materia oscura, y la radiación oscura", dice el líder del estudio y Premio Nobel Adam Riess, del Space Telescope Science Institute y de la Universidad Johns Hopkins, ambos de Baltimore (Maryland, EE.UU.) Los resultados aparecerán en un próximo número de la revista The Astrophysical Journal.

El equipo de Riess hizo el descubrimiento refinando la velocidad de expansión actual del universo con una precisión sin precedentes, reduciendo la incertidumbre a sólo el 2,4 por ciento. El equipo hizo los refinamientos desarrollando técnicas innovadoras que mejoran la precisión de las mediciones de las distancias a las galaxias lejanas.

El equipo buscó galaxias que contuvieran estrellas Cefeidas y supernovas de tipo Ia. Las Cefeidas pulsan a velocidades que corresponden a su verdadero brillo, que puede compararse con el brillo aparente visto desde la Tierra, para determinar con precisión su distancia. Las supernovas de tipo Ia, otra vara de medida cósmica de uso común, son explosiones de estrellas que estallan con el mismo brillo y son lo suficientemente brillantes para ser vistas desde distancias relativamente largas.

Mediante la medición de alrededor de 2.400 estrellas Cefeidas en 19 galaxias y comparando el brillo observado de ambos tipos de estrellas, midieron con precisión su verdadero brillo y calcularon distancias calculadas a unas 300 supernovas de tipo Ia en galaxias lejanas.

El equipo comparó esas distancias con la expansión del espacio, medida a partir del estiramiento de la luz de galaxias alejándose. El equipo utilizó estos dos valores para calcular cómo de rápido se expande el universo con el tiempo: la constante de Hubble.

El nuevo valor de la constante de Hubble es de 73,2 kilómetros por segundo por megaparsec. (Un megaparsec equivale a 3,26 millones de años luz.) Eso significa que la distancia entre los objetos cósmicos se duplicará en otros 9.800 millones de años.

Esta calibración refinada supone, sin embargo, un rompecabezas, debido a que no se ajusta exactamente a la velocidad de expansión prevista para el universo según su trayectoria observada poco después del Big Bang.

Las mediciones de la luminiscencia residual del Big Bang realizadas por la Sonda de Anisotropía de Microondas Wilkinson (WMAP) de la NASA y de la misión del satélite Planck de la Agencia Espacial Europea (ESA) producen estimaciones de la constante de Hubble un 5 y un 9 por ciento, respectivamente, más pequeñas.

"Si sabemos las cantidades iniciales de materia en el universo -de energía oscura y de materia oscura-, y hacemos bien los cálculos de física, se puede pasar de una medición justo posterior al big bang y utilizar ese conocimiento para predecir cómo de rápido debería estar expandiéndose el universo actualmente", dice Riess en la nota de prensa del portal del telescopio Hubble. "Sin embargo, si esta discrepancia se mantiene, puede que no lo estemos entendiendo bien".

Comparar la velocidad de expansión del universo con los datos de WMAP, Planck y el telescopio Hubble es como construir un puente, explica Riess. En la orilla distante están las observaciones de la radiación de fondo de microondas del universo temprano. En la orilla cercana se encuentran las mediciones realizadas por el equipo de Riess utilizando el Hubble. "Deberían cruzarse en el centro, pero no ocurre así", señala el investigador.

Hay algunas explicaciones posibles para el exceso de velocidad del universo. Una posibilidad es que la energía oscura, de la que se sabe que está acelerando el universo, podría estar separando a las galaxias unas de otras, con una fuerza aún mayor -o creciente-.

Otra idea es que el cosmos contuviera una nueva partícula subatómica en su historia temprana que viajaba cerca de la velocidad de la luz. Tales partículas rápidas se conocen colectivamente como "radiación oscura" e incluyen partículas ya conocidas como los neutrinos. Esa energía de radiación oscura adicional podría estar estropeando los esfuerzos para predecir la velocidad de expansión actual a partir de su trayectoria temprana.

El aumento en la aceleración también podría significar que la materia oscura posee algunas características extrañas e inesperadas. La materia oscura es la columna vertebral del universo sobre la cual las galaxias forman las estructuras a gran escala observadas en la actualidad.

Y, por último, este universo más rápido de lo previsto podría estar diciendo a los astrónomos que la teoría de la gravedad de Einstein es incompleta. "Sabemos muy poco acerca de las partes oscuras del universo, así que es importante medir la forma en que empujan y tiran del espacio a lo largo de la historia del cosmos", señala Lucas Macri, de la Universidad Texas A & M, colaborador clave en el estudio.

Antes de que el telescopio Hubble fuera lanzado en 1990, las estimaciones de la constante de Hubble variaban en un factor de dos. A finales de 1990 se redujo el margen de error a sólo el 10 por ciento, y ahora el objetivo es reducirlo a menos del 1 por ciento.

Fuente: Tendencias 21

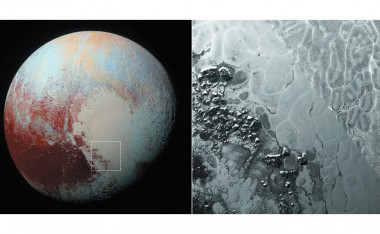

Resuelto el enigma de los polígonos que cubren la superficie de Plutón

En la vasta cuenca Sputnik Planum de Plutón han aparecido a lo largo de decenas de kilómetros unas misteriosas e irregulares figuras poligonales. Ahora, en dos artículos publicados en Nature se revela que en el interior de la gruesa capa de nitrógeno sólido que cubre el planeta enano se producen procesos de convección que están detrás de estas formaciones geométricas.

Este mecanismo de propagación del calor (provocado por diferencias de densidad entre los materiales) origina una contracción del terreno en la superficie, dejando las distintivas figuras poligonales. Tienen entre 10 y 40 kilómetros de diámetro, y muchas de ellas presentan los lados elevados.

La gélida planicie Sputnik Planum, con sus formas poligonales, es una de las superfcies más jóvenes de todo el sistema solar.

“Estas investigaciones demuestran que la Sputnik Planum es una de las superfcies más jóvenes del sistema solar”, aseguran Andrew J. Dombard y Sean O’Hara en una revisión de los trabajos publicados. “Es una planeta enano y helado, pero geológicamente dinámico”.

Para resolver el misterio sobre estas formaciones, un equipo liderado por el profesor del Centro de Ciencias del Espacio de Washington (EEUU) William McKinnon usó las mediciones que hizo la nave espacial New Horizons para mostrar que las capas de hielo, de más de un kilómetro de espesor, presentaban flujos de calor en su interior. Estos autores consideran que las convecciones podrían explicar la gran anchura lateral de los polígonos.

Por su parte, otra investigación liderada por Alexander Trowbridge, profesor en Universidad Purdue de Indiana (también en EE UU) analiza la existencia de los polígonos usando otra técnica. En su trabajo, aplicaron modelos numéricos al nitrógeno sólido y también comprobaron que este hielo está sometido a mecanismos de convección en su interior.

¿Más polígonos en el sistema solar?

Los autores piensan que este tipo de mecanismos, con los que se renuevan las capas de hielo continuamente, pueden estar produciéndose en otros planetas enanos del cinturón de Kuiper, un conjunto de objetos que va más allá de la órbita de Neptuno y del que se sabe muy poco. El nuevo avance sobre la formación de polígonos sobre la superficie de planetas helados permite aventurar situaciones similares en otros lugares del espacio.

"Plutón nos muestra que los procesos planetarios funcionan de manera similar con independencia del lugar del sistema solar donde ocurran”, valoran los profesores Paul Schenk del Instituto Planetario y Lunar de Texas (EE UU) y Francis Nimmo de la Universidad de Santa Cruz en otro artículo publicado también en Nature Geoscience.

Fuente: Agencia SINC

Vivir en peligro deja huellas en las neuronas

Cuando una gaviota vuela en forma amenazante sobre la playa, los cangrejos saben que tienen que correr a guarecerse en su cueva. Sin embargo, en las playas de San Antonio Oeste, en la provincia de Río Negro, es posible caminar tranquilamente por la orilla sin que los cangrejos se inmuten.

¿A qué se debe tanta tranquilidad? ¿Será que las características del entorno influyen en el comportamiento de estos animales y dejan una huella en sus cerebros? Estas son las preguntas que se formuló Daniel Tomsic, profesor en la Facultad de Ciencias Exactas y Naturales de la UBA e investigador UBA-CONICET, quien, desde hace varios años, se dedica a estudiar la respuesta de los cangrejos frente a estímulos visuales indicadores de peligro.

“A partir del comentario de colegas de Mar del Plata acerca de la poca reacción de los cangrejos de San Antonio Oeste, y nuestro conocimiento sobre las reacciones de estos mismos cangrejos en otros sitios, decidimos comparar el comportamiento y las modificaciones en el sistema nervioso en animales de la misma especie que se encuentran naturalmente expuestos a mayor o menor presencia de predadores”, relata Tomsic desde el Instituto de Fisiología Biología Molecular y Neurociencias (IFIBYNE) del CONICET y UBA.

Ambas poblaciones de cangrejos viven en ambientes de estuario, que están aislados unos de otros por cientos de kilómetros. Ambos grupos de animales viven vidas muy distintas. Los que habitan en la costa de Mar Chiquita están sometidos a los ataques permanentes de las gaviotas. En cambio, los cangrejos de San Antonio Oeste no sufren esa presencia amenazante, y su vida es más apacible.

Los investigadores decidieron recolectar animales de ambos lugares y estudiarlos en el laboratorio. Así, evaluaron la intensidad con la que respondían a objetos que se movían por encima de sus cabezas, simulando el vuelo rasante de una gaviota. “Encontramos que, de acuerdo a lo esperado, los cangrejos de Mar Chiquita, donde hay más predadores, respondían en forma mucho más intensa”, señala Tomsic, y destaca: “Al registrar la respuesta de las neuronas, vimos que ésta también era más intensa, de modo que había una correspondencia entre la actividad de las neuronas y el comportamiento de los animales relacionada con el riesgo de predación”. Los resultados se publicaron en el Journal of Experimental Biology.

Por su parte, Tomás Luppi y Jesús Nuñez, investigadores del CONICET en la Universidad de Mar del Plata y también autores del trabajo publicado, analizaron la proporción de cangrejos que se convierten a diario en alimento de las gaviotas, y determinaron que ese valor es mucho mayor en Mar Chiquita, es decir, el riesgo para la vida del cangrejo es superior en esas playas bonaerenses.

Desde el punto de vista de la teoría de la evolución, un factor de importancia en los cambios que se producen en las especies es el impacto de la acción de los predadores. Es decir, esa amenaza termina modulando el comportamiento de las especies afectadas.

La originalidad del trabajo realizado por los investigadores reside en mostrar no sólo que la presencia o ausencia de predadores modula el comportamiento de los animales, sino también que ese comportamiento es consecuencia de la actividad de sus neuronas.

“Hasta el momento no había ninguna evidencia de que el impacto de predación podía afectar la respuesta a nivel de neuronas individuales, y eso es lo que pudimos mostrar”, asegura Tomsic.

El investigador aclara que los resultados en cuanto al comportamiento fueron los esperados, pero remarcó que “no es tan fácil vincular directamente el comportamiento con un grupo de neuronas individuales”. Además, el estudio fue posible gracias a la posibilidad de disponer de dos poblaciones de una misma especie que estuvieran aisladas entre sí.

De todos modos, el trabajo abre nuevas preguntas, por ejemplo, si las diferencias halladas en las neuronas se corresponden con una variación genética. Es decir, no se sabe si se trata de un cambio que se produce durante el período de vida de los animales, que genéticamente tienen la misma estructura, o si, por el contrario, esa diferencia se encuentra determinada por los genes. En tal caso, se trataría de dos poblaciones que se están diferenciando genéticamente.

Si estas poblaciones estuvieran en proceso de diferenciación, se trataría, según indican los investigadores, de un caso de microevolución, pues se observan pequeñas diferencias en la manera en que responden determinadas neuronas. Para confirmarlo, una alternativa es criar animales de las dos poblaciones en un mismo ambiente y ver si las diferencias en las neuronas se mantienen cuando los animales se hacen adultos.

En resumen, el trabajo con los cangrejos nacidos y criados en dos ambientes distintos de la costa atlántica confirman algunos supuestos que surgen de la teoría de la evolución, como el hecho de que el impacto de los predadores influye en el comportamiento. La originalidad reside en que muestra algo que hasta el presente no había podido ser confirmado: que una diferencia ecológica de mucha relevancia, como el impacto de predación, se corresponde con una diferencia en la actividad de las neuronas. Si bien existen estudios que establecen correlaciones entre algunas variables ecológicas y el tamaño del cerebro del animal, nunca se habían realizado comprobaciones de cambios a nivel de neuronas individuales.

Fuente: NEX Ciencia

Un paso más hacia una vacuna universal contra el cáncer

El cáncer no es una invasión de cuerpos extraños como las bacterias o los virus. Esta enfermedad es una especie de reverso tenebroso de nosotros mismos, nuestras propias células enloquecidas, que la convierte en un enemigo muy difícil de combatir. Durante décadas, la opción farmacológica más frecuente contra la enfermedad ha consistido en envenenar a todas las células del cuerpo con la esperanza de que las cancerosas sufran más que las sanas (la quimioterapia). En los últimos años, sin embargo, han aparecido nuevas opciones más efectivas y menos tóxicas.

Uno de estos métodos, cada vez más generalizado y menos experimental, consiste en ayudar al sistema inmune a identificar las células cancerosas para que las destruya. La más común de estas inmunoterapias consiste en desmontar las estratagemas moleculares que utiliza el cáncer para confundirse entre las células normales. De esa manera, los glóbulos blancos son capaces de detectarlas y atacarlas.

Durante muchos años, los científicos han tratado de emplear contra el cáncer el sistema de inmunoterapia más efectivo que conocemos: las vacunas. Estas sustancias introducen en el cuerpo algo que se asemeja al microbio que se quiere combatir. El sistema inmune se prepara así para reconocer a una amenaza contra la que en principio no estaba preparado. Sin embargo, las células tumorales se parecen demasiado a las sanas y los antígenos que suelen servir al sistema inmune para detectar los objetivos que se deben aniquilar se expresan en ambas de forma similar.

En un artículo que se publicó en la revista Nature, un equipo de investigadores de la Universidad de Maguncia (Alemania) explica cómo han logrado desarrollar un sistema que podría ser un primer paso para crear una vacuna universal contra el cáncer. Los autores trataron de alcanzar las células dendríticas del sistema inmune, capaces de provocar una respuesta contra los tumores, y para lograrlo, empaquetaron ARN (las moléculas que le permiten al ADN producir proteínas) con lípidos y se lo inyectaron a ratones. El envoltorio de lípidos conservó el ARN, que normalmente habría sido descompuesto por el organismo, y le permitió llegar a las células dendríticas y los macrófagos (un tipo de glóbulos blancos) presentes en el bazo, los nódulos linfáticos o la médula ósea. Allí, el ARN se convirtió en un antígeno específico para el cáncer, dando la señal necesaria para desatar una respuesta inmune dirigida y potente contra la enfermedad.

Los investigadores probaron el sistema en varios modelos de tumores en ratones observando una intensa reacción de los glóbulos blancos ante el antígeno inyectado en los animales. Además, en un pequeño ensayo con tres enfermos de melanoma también observaron que el mecanismo tenía los efectos esperados y se producía una respuesta del sistema inmune. En opinión de los autores, el hecho de que casi cualquier antígeno se pueda codificar en ARN, este tipo de vacunas podría adaptarse a cualquier tipo de cáncer para provocar un efecto inmunitario contra el cáncer similar.

Los investigadores quieren probar la técnica en melanoma, cáncer de mama y cáncer de cuello y cabeza.

"El reto técnico es que cada tumor es diferente y tiene otros rasgos característicos, por lo que no puedes utilizar una vacuna idéntica para cada paciente", apunta Ugur Sahin, director de TRON, una organización de investigación biofarmacéutica de la Universidad de Maguncia dedicada a buscar nuevos fármacos contra el cáncer. Sin embargo, añade, "el enfoque de la vacuna es como un sobre en el que puedes introducir cualquier información vacunal". Y explica: "El sobre transporta esta información a las células dendríticas que extraen la información y la utilizan para entrenar a otras células inmunitarias. Eso significa que podemos personalizar e incluso individualizar la vacuna utilizando este concepto universal".

Marisol Soengas, jefa del Grupo de Melanoma del CNIO (Centro Nacional de Investigaciones Oncológicas), considera que, aunque la idea de partida no es nueva, el grupo de la Universidad de Maguncia “ha logrado su objetivo de una forma muy sencilla”, un concepto que “resulta interesante”. Sobre la universalidad de un tratamiento como este para atacar a los tumores, aunque considera que es posible, no cree que “los datos que tienen sean suficientes” para poder afirmar que se va a conseguir una vacuna universal contra el cáncer.

Los autores del trabajo que publica Nature están probando ahora su técnica con más pacientes y quieren ampliar el uso de su vacuna a otros tipos de cáncer. Según explica Sahin, están "preparando ensayos clínicos en melanoma, cáncer de mama triple negativo [los de peor pronóstico] y cáncer de cabeza y cuello en 2016, y en 2017 queremos realizar ensayos clínicos de mayor tamaño para varios tipos de cáncer".

Fuente: El País

Científicos de EEUU intentan desarrollar órganos humanos en cerdos

Un grupo de científicos de Estados Unidos está intentando cultivar órganos humanos en cerdos inyectando células madre en embriones de cerdo para producir embriones de cerdo humano conocidos como quimeras. Esta investigación, impulsada desde la Universidad de California, intenta luchar contra la escasez mundial de órganos de trasplante.

El equipo de la Universidad de California cree que los animales resultantes tendrán la apariencia y el comportamiento de cerdos normales con la salvedad de que uno de sus órganos, de momento el páncreas, estará compuesto por células humanas. La implantación de embriones quiméricos de cerdo-humano está permitida hasta 28 días antes de que la gestación haya terminado. El tejido se retira después para analizarlo.

Pablo Ross, biólogo especializado en reproducción al frente de la investigación, asegura que tienen la esperanza de que el embrión de cerdo resultante se desarrolle con normalidad con la salvedad de que su páncreas esté formado exclusivamente de células humanas y pueda ser compatible con un paciente humano para trasplante. Su proyecto no está exento de polémica. El año pasado la principal agencia de investigación médica, the National Institutes of Health, impuso una moratoria para financiar estos experimentos. La preocupación principal es que las células humanas puedan emigrar al cerebro del cerdo en desarrollo y lo hagan, de algún modo, más humano.

Otros equipos de investigación han creado embriones de cerdo humano pero ninguno ha permitido que los fetos lleguen a nacer. Walter Low, profesor en el departamento de neurocirugía de la Universidad de Minessota cree que utilizar a los cerdos como incubadoras biológicas para desarrollar órganos humanos podría ser utilizado potencialmente para hacer crecer no solo un páncreas, sino también corazones, hígados, riñones, pulmones o córneas.

Fuente: El País

La acumulación de neuronas muertas en el cerebro

agrava las enfermedades mentales

agrava las enfermedades mentales

Un grupo internacional de científicos ha investigado por primera vez cómo funciona el proceso de fagocitosis que llevan a cabo las células “detectoras de la basura cerebral”: la microglía. Han descubierto que, tras producirse muerte o lesión neuronal en cerebros enfermos, estas células se vuelven “ciegas” y no son capaces de realizar su función. Esto desencadena una respuesta inflamatoria que agrava la lesión cerebral sufrida.

Cuando nos hablan de células muertas, inmediatamente pensamos en las células de la piel. Éste es un proceso que no nos resulta extraño. Las células de nuestra piel mueren y, para evitar su acumulación, nos aconsejan una serie de procedimientos sencillos. Sin embargo, debemos ser conscientes de que en nuestro organismo, las células de la piel no son las únicas que mueren.

Las neuronas del cerebro también lo hacen. Sabemos que estas células mueren tras completar su ciclo natural de vida, por envejecimiento, o debido a lesiones cerebrales traumáticas y enfermedades neurodegenerativas. Pero, ¿nos hemos planteado alguna vez qué ocurre con ellas después de muertas? ¿Cómo puede eliminarlas nuestro organismo ? O, si no son eliminadas, ¿qué sucede entonces?

Ahora equipo multidisciplinar de investigadores ha estudiado por vez primera los procesos de muerte neuronal y de fagocitosis o eliminación de neuronas muertas, llevado a cabo por la microglía de cerebros enfermos. En su estudio describen el funcionamiento de los mecanismos de limpieza del cerebro cuando los pacientes sufren enfermedades neurodegenerativas, concretamente epilepsia.

Para llevar a cabo el estudio, publicado en la revista PloS Biology, los científicos recogieron muestras de cerebro de pacientes que padecían epilepsia, así como de ratones epilépticos.

Los resultados mostraron que las células de la microglía presentaban un comportamiento anómalo, y eran incapaces de eliminar las neuronas muertas. En consecuencia, estas neuronas se acumulan como residuos y provocan el desencadenamiento de una respuesta inflamatoria que empeora la lesión cerebral.

Microglía y enfermedades neurodegenerativas

La muerte de neuronas es un proceso natural de envejecimiento que ocurre en el desarrollo normal del sistema nervioso de todos nosotros. Un fenómeno neuronal al que estamos abocados todos los seres humanos.

En condiciones normales, la eliminación de esta “basura” cerebral permite que el tejido cerebral próximo no sufra ningún tipo de alteración y pueda seguir funcionando de forma adecuada. Este proceso de eliminación se denomina fagocitosis, y las encargadas de realizarlo son las llamadas células de la microglía, que elaboran la primera reacción inmune natural del cerebro, crucial para preservar la integridad del sistema nervioso.

La fagocitosis, por lo tanto, es un proceso esencial para mantener la homeostasis ante un gran número de enfermedades inflamatorias y autoinmunes. Pero su papel en el cerebro está poco estudiado.

Las células de la microglía están continuamente analizando su medio. Presentan una gran cantidad de ramificaciones que están en constante movimiento por todo el cerebro. Gracias a esta particularidad, cuando se produce un daño en el sistema nervioso, reaccionan y migran hacia la zona en cuestión.

Una vez allí, repararan el tejido liberando diferentes componentes que permiten eliminar elementos extraños, no deseados o dañados, mediante la fagocitosis. Sin embargo, estos componentes, en algunas ocasiones, pueden afectar a las neuronas sanas y provocar una eliminación excesiva e innecesaria de neuronas. Esto, que ocurre en enfermedades como el Parkinson y el Alzheimer, origina un ambiente patológico.

Al menos, esto era lo que se creía que ocurría, pues se presuponía la eficacia de la microglía como recolectoras y destructoras (fagocitos) de residuos, también en cerebros enfermos.

Sin embargo, la nueva investigación señala que puede ocurrir todo lo contrario, es decir que, en cerebros enfermos o lesionados, la microglía no elimine neuronas muertas que sí debrían de ser eliminadas para evitar una respuesta inflamatoria del cerebro. Este hecho tendría una grave repercusión patológica.

El experimento

Para comprobar si la microglía se comportaba como fagocitos eficaces en un cerebro enfermo, el equipo de investigación, dirigido por la Dra. Amanda Sierra, directora del laboratorio de Biología Celular Glial del Achucarro Basque Center for Neuroscience (País Vasco), indujo experimentalmente una serie de procesos apoptóticos (que inducen a las células a morir cuando están dañadas).

Con la inducción de estos procesos se observó cómo respondía la microglía, de una forma generalizada. Lo que hacían estas células era establecer diferentes estrategias que mejorasen su eficacia fagocítica. Es decir, aumentaban su capacidad de captación de la “basura celular”.

De esta manera, en caso de generarse un incremento de células apoptóticas (células dañadas que están programadas para morir y evitar enfermedades como el cáncer), la microglía era capaz de mantener una relación adecuada y equilibrada entre la apoptosis y la fagocitosis.

Sin embargo, la sorpresa llegó cuando estudiaron muestras de cerebro extraídas de personas que padecían epilepsia y de ratones epilépticos, desarrollados experimentalmente. En estos casos, se detectó que la relación existente en condiciones normales entre la apoptosis y la fagocitosis de la microglía se perdía de forma crónica.

Este trabajo ha sido el primero en cuantificar el proceso de fagocitosis en el cerebro de personas enfermas de epilepsia.

El descubrimiento

Así que, en el caso de pacientes con epilepsia, la microglía no actúa, digamos que “está ciega”. Por eso no logra detectar las neuronas muertas, y éstas no pueden ser eliminadas ni destruidas, lo que tiene consecuencias nefastas para el paciente.

La inactividad de la microglía hace que la fagocitosis no se lleve a cabo, lo que conlleva que se produzca una enorme acumulación de neuronas muertas en el cerebro. Un acúmulo excesivo de residuos que, al igual que la basura en los basureros, comienza a descomponerse.

En las neuronas muertas, la membrana se va haciendo cada vez más permeable, lo que permite la liberación de compuestos tóxicos presentes en su interior. Esos compuestos dañan a las neuronas vecinas, lo que provoca una respuesta inflamatoria del cerebro que lo daña todavía más.

En el caso concreto de la epilepsia, se sabe que, en algunas ocasiones y durante las convulsiones, las neuronas mueren. Así que el hecho de que la fagocitosis no se realice favorece la inflamación producida en el cerebro. Esto fomenta la aparición de crisis epilépticas, caracterizadas por las impactantes convulsiones.

En un futuro

Este hallazgo abre vías para el desarrollo de nuevas terapias que permitan paliar los efectos de las enfermedades cerebrales, terapias que “enseñen” a la microglía a mejorar su eficacia para la correcta eliminación de neuronas muertas.

De hecho, el equipo de investigación está ya trabajando en el desarrollo de fármacos que promuevan este proceso de limpieza, es decir, que en condiciones lesionadas activen el proceso de fagocitosis. Esto permitiría ayudar en los tratamientos de enfermedades como la epilepsia.

Fuente: Tendencia 21

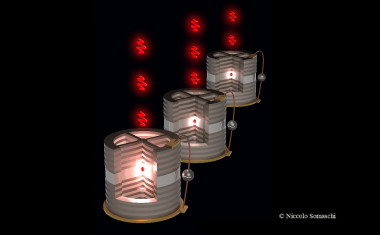

Una nanofuente cuántica mana fotones de uno en uno

Las aplicaciones de la fotónica cuántica resolverán en el futuro desafíos que hoy son imposibles de afrontar con las tecnologías actuales, en campos como las telecomunicaciones, la detección de alta sensitividad y la computación cuántica. Pero para lograr esto se necesitan fuentes de luz que puedan emitir fotones idénticos y de uno en uno.

Ahora, un equipo de científicos del Centro Nacional para la Investigación Científica (CNRS) en Francia ha logrado crear una nanofuente que ‘mana’ fotones individuales de una forma muy eficiente y que, además, son indistinguibles al 99,5% unos de otros. El estudio, publicado en la revistaNature Photonics, lo ha dirigido Pascale Senellart en el Laboratorio de Fotónica y Nanoestructuras del CNRS.

“Nuestro dispositivo consiste en un punto cuántico (formado por un material semiconductor de unos cuantos nanometros) en medio de una cavidad óptica con forma de pilar, de unas tres micras”, explica a Sinc Daniel Lanzillotti, investigador argentino del CNRS y coautor del trabajo.

Para que un punto cuántico pueda emitir fotones idénticos debe estar totalmente aislado de su entorno, y el equipo lo ha conseguido aplicando un campo eléctrico. De esta forma, han reducido el ‘ruido’ externo que provoca que los fotones sean distinguibles, un efecto no deseado.

“La mayor aportación de nuestro dispositivo es el número de fotones únicos y casi indistinguibles que puede emitir por segundo (alrededor de 13 millones), lo que supone 20 veces más que lo que aportan las fuentes de SPCD (Spontaneous Parametric Down-Conversion) que se usan actualmente”, destaca el científico español Carlos Antón, estudiante postdoc y participante también en la investigación.

Antón explica que "un fotón individual e idéntico al resto (con igual longitud de onda, polarización, perfil espacial y temporal) constituye un bit cuántico, una unidad elemental de información con propiedades cuánticas –como la posibilidad de formar un estado mixto entre 0 y 1– para poder realizar operaciones solo accesibles de la mano de la física cuántica”.

Según los autores, estas nanofuentes de fotones únicos se pueden implementar directamente en experimentos de computación óptica-cuántica. Además, sus posibles aplicaciones se extienden a otros campos de la información cuántica, la criptografía, el desarrollo de detectores ultrasensibles e incluso en supercomputación de sistemas biológicos.

Fuente: Agencia SINC

Nueva técnica inédita mejora el tratamiento de fertilización asistida

El equipo de trabajo intenta detectar, en el medio donde crecen los embriones y a través de un método fisicoquímico, si existe un perfil metabólico característico de un embrión que tiene alta probabilidad de implantar en relación a otro con bajo potencial de implantación. El proyecto recibió el premio “Innovar 2015”, el concurso de innovaciones más importante del país.

Las parejas acuden a la fertilización asistida luego de haber intentado otras metodologías para tratar la infertilidad; no son los tratamientos de primera instancia. En general, en los centros especializados a través de un tratamiento hormonal de estimulación ovárica se obtiene de la madre un número significativo de óvulos, que son fertilizados “in vitro” con espermatozoides para obtener los respectivos embriones, los cuales son cultivados en medios de cultivo apropiados entre tres y cinco días.

El gran desafío que tiene la fertilización es determinar con precisión cuál, o cuáles de esos embriones transferir a las madres en primera instancia para tener las mayores probabilidades de éxito en la implantación.

Alejandra Bosch, una de las investigadoras que conforma el equipo encargado de abordar el tema, explicó que “hasta ahora los métodos que se emplean universalmente para seleccionar el, o los embriones, para transferir a las madres, consisten en realizar un análisis microscópico para examinar la morfología, la forma del embrión y las células que lo integran”.

En la actualidad comienzan a implementarse nuevos métodos que buscan filmar el desarrollo del embrión y asociar su evolución durante los tres o cinco días de incubación con su potencial de implantación. Por su parte, Osvaldo Yantorno, otro de los investigadores, explicó que “al estudio del metabolismo lo realizamos a partir del análisis del sobrenadante de cultivo donde crece el embrión, basándonos en que cuando una célula se desarrolla en un medio de cultivo, consume nutrientes y libera productos de desecho”. En este sentido, detalló que “la idea es estudiar ese medio donde se desarrolló el embrión, en este caso, con una metodología que es la espectrocospia infrarroja con transformada de Fourier”.

Las estadísticas de tasa de embarazo por fertilización asistida son bastante bajas; están en un orden del 25 al 30 por ciento. Dados los altos costos de estos tratamientos, el gran desafío en la actualidad es tratar de aumentar este porcentaje de certeza. En muchos casos, para disminuir los costos que implica realizar sucesivos tratamientos, se tiende a transferir tres o más embriones simultáneamente, lo que aumenta en forma significativa los riesgos, tanto para la madre como para los bebés. Este proyecto apunta, entonces, a desarrollar una metodología que permita transferir la menor cantidad de embriones con la mayor probabilidad de éxito en la implantación.

El equipo de investigación desarrolla su actividad en el Centro de Investigación y Desarrollo de Fermentaciones Industriales (CINDEFI), dependiente de la Facultad de Ciencias Exactas y Conicet. Participa también una becaria del Conicet, Cecilia Fígoli, quien explicó que la idea es elegir el mejor embrión de manera de alcanzar el gran objetivo de 1 embrión transferido = 1 embarazo.

Durante dos años y medio, el equipo de investigadores recibió material de una clínica de fertilización asistida de Buenos Aires PREGNA, Medicina Reproductiva, dirigida por el doctor Marcos Horton.

En este marco, la Facultad de Ciencias Exactas recibió los sobrenadantes de cultivos de embriones de más de 250 pacientes. “A lo largo de este tiempo estuvimos analizando los medios de cultivo donde desarrollaron embriones, algunos transferidos con éxito y otros que no implantaron”. En este momento, la investigación se encuentra en la última etapa que consiste en analizar matemáticamente los espectros provenientes de estos sobrenadantes empleando diferentes tipos de software, estudiando si existe algún “marcador” que permita diferenciar los espectros que provienen de embriones que implantaron de los que no implantaron. Para esto se requiere disponer de software especializados y también de conocimientos matemáticos y estadísticos.

En esta última etapa colaboran en el proyecto grupos de espectroscopistas de Noruega y Alemania, especialistas en el desarrollo de modelos matemáticos, por lo que se espera que luego de un trabajo cooperativo entre diferentes centros de investigación el resultado sea exitoso.

Fuente: El otro mate

No hay comentarios:

Publicar un comentario