A continuación, compartimos con todos Uds. un resumen de las novedades más destacadas del mundo de la ciencia y la tecnología.

El ARSAT-1 completó con éxito el testeo

en órbita de todos sus sistemas

en órbita de todos sus sistemas

El procedimiento, dirigido desde la Estación Terrena Benavídez por técnicos de ARSAT e INVAP, permitió comprobar en vuelo el correcto funcionamiento del ARSAT-1, el primer satélite geoestacionario de telecomunicaciones de la Argentina.

El In Orbit Test (IOT), como se denomina a estas pruebas, se inició el 31 de octubre y el 18 de noviembre, arrojando resultados positivos para el funcionamiento de todos los subsistemas del satélite: el térmico, el de potencia, el de aviónica y el de carga útil.

Respecto de la plataforma, se probaron los equipos del módulo de servicios (la computadora de a bordo, la unidad controladora de potencia y el módulo de interfase), los sensores (estelares, de Sol y giróscopo), los actuadores (como las ruedas de inercia, que son las que compensan el movimiento del satélite y colaboran con su estabilización) y los calentadores (que permiten, cuando el satélite no recibe luz solar, mantener su temperatura operativa, que oscila entre los 20 y los 40 grados).

También fue testeada en vuelo la carga útil. En una primera fase, se probaron los equipos nominales receptores de señal, los amplificadores y transmisores. Más tarde se chequeó el correcto funcionamiento de los equipos redundantes de recepción de comunicaciones y de amplificación de señal. Y luego se realizó el llamado mapeo de antena que, mediante leves movimientos en sentido Este, Oeste, Norte y Sur, modifica la "actitud" del satélite en relación con la Tierra. De este modo, desde la Estación Terrena Benavídez se pudo también comprobar que la antena de comunicaciones tiene la potencia correcta requerida para la prestación de servicios a cualquier punto del territorio argentino.

Fuente: Argentina

Invap vendió equipos a EE.UU

para producción de radioisótopos medicinales

para producción de radioisótopos medicinales

La empresa estatal INVAP, dedicada al desarrollo de sistemas tecnológicos complejos, fue contratada por una compañía con sede en Estados Unidos para el diseño de dos reactores de investigación y producción de radioisótopos, y una planta de procesamiento de radioisótopos, que se radicarán en el estado de Florida.

La compañía Coquí Radio Pharmaceuticals, nacida en Puerto Rico, se interesó hace unos años en la producción de uranio levemente enriquecido para la obtención de Molibdeno 99, y después de un exhaustivo análisis de distintas compañías se decidió por la firma argentina.

Para Juan Pablo Ordóñez, subgerente general de INVAP y suscriptor del contrato, la conquista de un mercado tan importante "es la confirmación de la competitividad a nivel internacional que tienen, tanto INVAP, como el sector nuclear argentino y la tecnología argentina en general. Actualmente, tenemos contratos en el área nuclear en Arabia Saudita, Argelia, Brasil, India y ahora Estados Unidos".

En el reactor desarrollado por INVAP para la empresa Coquí Radio Pharmaceuticals se irradian blancos de uranio levemente enriquecido. La fisión del uranio en los blancos produce, entre otros muchos productos de fisión, Molibdeno 99.

Desde la empresa farmacéutica informaron que los reactores y la planta estarán operativos en 2020, y se transformará en la primera compañía en Estados Unidos en producir comercialmente el insumo de todas las prácticas y estudios de la medicina nuclear. Sobre los costos del emprendimiento y el monto del contrato con INVAP, las partes evitaron dar precisiones por ser información reservada a los inversores.

Los dos reactores tendrán capacidad de aproximadamente 10 megawatts de potencia y serán específicos para la producción de radioisótopos, en conjunto con la planta de procesamiento. La tecnología utilizada y el método de producción es un desarrollo de la Comisión Nacional de Energía Atómica (CNEA).

La iniciativa se suma a los proyectos ya finalizados por INVAP en el área nuclear, como el reactor multipropósito OPAL para Australia, que demandó una inversión de 250 millones de dólares. Además, en cooperación con la CNEA, se trabaja en el RA10, otro reactor multipropósito que se construirá en la localidad de Ezeiza, con una inversión nacional de 300 millones de dólares.

Fuente: Argentina

La "máquina de Dios" halló

dos partículas nunca vistas

dos partículas nunca vistas

Científicos en el Gran Colisionador de Hadrones de la Organización Europea para Investigación Nuclear (CERN) afirman haber descubierto una nueva partícula subatómica nunca vistas hasta ahora y que podrían ampliar nuestra compresión del universo.

Se trataría de un barión, el cual podría ayudar a comprender cómo funcionan la teoría física del "modelo estándar", que explica que toda la materia se compone de partículas elementales.

Los funcionarios del laboratorio anunciaron el descubrimiento de los bariones a raíz de la unión de tres quarks (constituyentes fundamentales de la materia) por una fuerza poderosa.

Fuente: Clarín

Fuente: Agencia Sinc

Lanzan cuchara inteligente que reduce

los temblores del Parkinson

los temblores del Parkinson

La última incorporación en el elenco de inventos de Google X, los laboratorios futuristas de la compañía de Mountain View, es una cuchara inteligente que ayuda a las personas que sufren temblores provocados por el Parkinson a comer por sí solas.

Gracias a una serie de sensores incorporados en el mango, esta cuchara llamada Liftware detecta el movimiento generado por los temblores involuntarios y automáticamente controla dicho temblor, permitiendo una cierta estabilidad.

LiftLab, la empresa desarrolladora que fue adquirida por Google en septiembre, logró reducir los temblores y mantener el equilibro hasta un 76%, según lo observado en los ensayos clínicos.

El Parkinson es la segunda enfermedad neurodegenerativa en prevalencia después del Alzheimer y afecta aproximadamente a 4 millones de personas a nivel mundial.

Fuente: Argentina Investiga

Identifican el punto débil del cerebro

frente a la demencia

frente a la demencia

El cerebro tiene un punto débil para la enfermedad de Alzheimer y la esquizofrenia, según los científicos del Reino Unido. El área del cerebro implicada se desarrolla al final de la adolescencia y degenera pronto durante el envejecimiento.

El equipo de investigadores británicos realizó imágenes de resonancia magnética en 484 voluntarios sanos de edades comprendidas entre ocho y 85 años. Luego, examinaron la forma natural en la que cambia el cerebro con la edad. Las imágenes revelaron un patrón común: las partes del cerebro que fueron las últimas en desarrollarse también fueron las primeras en mostrar signos de deterioro relacionados con la edad.

Cuando los investigadores analizaron los escáneres de los pacientes con enfermedad de Alzheimer y los de pacientes con esquizofrenia encontraron que las mismas regiones del cerebro estaban afectadas. Los hallazgos concuerdan con lo que otros expertos han sospechado - que, aunque sean enfermedades distintas, el Alzheimer y la esquizofrenia están vinculadas.

Este estudio a gran escala y detallado proporciona un importante vínculo entre el desarrollo, el envejecimiento y los procesos de enfermedad en el cerebro. Además, plantea cuestiones importantes acerca de los posibles factores genéticos y ambientales que pueden ocurrir en la vida temprana y que luego tienen consecuencias para toda la vida.

Fuente: BBC Mundo

Las universidades nacionales más nuevas

serán las más beneficiadas por el presupuesto

serán las más beneficiadas por el presupuesto

Con el presupuesto de las universidades nacionales para 2015 aprobado, un informe del Centro de Estudios de la Educación Argentina (CEA), que dirige Alieto Guadagni en la Universidad de Belgrano (UB), advirtió grandes diferencias si se calcula el presupuesto de las partidas específicas dedicadas a la enseñanza por cada alumno, es decir, sin tomar en cuenta las erogaciones en salud (hospitales universitarios) y en investigación en ciencia y tecnología.

En ese sentido, entre las universidades que más dinero recibirán por alumno para educación y cultura se encuentran varias de las instituciones universitarias más nuevas, creadas a partir de 2009, como la de Avellaneda, Moreno o la Arturo Jauretche, de Florencio Varela.

El caso más significativo que surge del informe es el de la Universidad Nacional de Avellaneda (Undav), creada en 2009 y que cuenta con 694 alumnos, que recibirá 152.679 pesos por cada estudiante, mientras que la Universidad de Buenos Aires(UBA), con 380.098 alumnos -la que cuenta con la mayor cantidad de estudiantes del país-, recibirá 17.077 pesos para cada uno, es decir, casi nueve veces menos que la de Avellaneda.

Para 2015, el presupuesto para las universidades nacionales alcanza los 38.533 millones de pesos, lo que equivale al 0,8 por ciento del PBI. "Si se consideran únicamente las partidas específicas dedicadas a la enseñanza, con una población universitaria de 1.522.502 alumnos (según la estimación hecha en el presupuesto 2015), el presupuesto promedio por alumno llega a 24.994 pesos por año", sostiene el informe.

De tenerse en cuenta el presupuesto total, que abarca los rubros de salud, educación y cultura, y ciencia y técnica, las universidades más antiguas son las que lideran la distribución de partidas presupuestarias. En primer lugar se encuentra la UBA, que recibirá 6690 millones de pesos (17,4 por ciento del total); seguida por Córdoba, con 2688 millones de pesos (7% del total); La Plata, con 2655 millones de pesos (6,9 por ciento del total), y la UTN, con 2646 millones de pesos (6,8%). Entre las cuatro concentran el 38,1% del total presupuestado, pero el 46,2 % del alumnado.

Sin embargo, el informe del CEA advierte que si se consideran únicamente las partidas específicas dedicadas a la enseñanza y si se tiene en cuenta además la cantidad de alumnos de cada universidad, la situación cambia significativamente: entre las que más dinero recibirán en 2015 están las de Avellaneda, Moreno, San Juan, Patagonia San Juan Bosco, Río Negro y Arturo Jauretche, mientras que las que menos recibirán son las de La Rioja, La Matanza (que tiene 37.484 alumnos), Lomas de Zamora y la UBA.

Fuente: La Nación

Dos estrellas a punto de fusionarse

MY Camelopardalis (MY Cam) es un sistema solar compuesto por dos estrellas que orbitan alrededor de un centro en común (como se muestra en la figura a continuación), lo que se conoce como una estrella binaria. Hasta la fecha era la más masiva conocida, pues está compuesta por astros 38 y 32 veces mayores que la masa del Sol.

Mediante el estudio del brillo del sistema MY Cam (cuya noción se puede apreciar en la siguiente animación), los astrónomos pudieron calcular que el periodo orbital del sistema es da tan sólo 1,2 días. Dado el tamaño de las estrellas, tienen que estar enormemente cerca para poder dar una vuelta completa en tan poco tiempo.

Además, el gran tamaño de estas estrellas hace que no se acomoden fácilmente a una órbita tan pequeña, con lo cual los investigadores han concluido que los astros se están tocando y que el material de sus capas exteriores forma una envoltura común, lo que en astrofísica se conoce como una 'binaria de contacto'.

Así, los investigadores creen que la evolución del sistema dará lugar a la fusión de las dos estrellas en un único objeto, aunque los detalles del proceso de fusión se desconocen. Algunos modelos teóricos sugieren que el proceso de fusión será extremadamente rápido, liberando una enorme cantidad de energía en una especie de explosión. Otros trabajos favorecen un proceso menos violento, pero en cualquier caso espectacular.

De todos modos, muchos astrofísicos creen que la fusión de las componentes de una binaria muy cercana es quizá la manera más efectiva de generar estrellas extremadamente masivas. MY Cam es el primer ejemplo de un sistema que puede dar lugar a uno de estos objetos.

Fuente: El Mundo

Fuente: Agencia Sinc

Despertó la sonda espacial que llegará a Plutón

Después de un viaje de casi nueve años y recorrer tres más de 4.800 millones de kilómetros, la sonda New Horizons (Nuevos horizontes) de la NASA despertó de su hibernación y ya está lista estudiar de cerca a Plutón en 2015. "New Horizons" está saludable y cruza silenciosa el espacio profundo, a cerca de 3.000 millones de millas de casa.

La agencia espacial informó que la sonda transmitió un mensaje a la Tierra, de donde fue lanzada en enero de 2006, tras salir de una hibernación de 1.873 días, cerca de dos tercios de su viaje, para preservar la energía eléctrica de la nave y minimizar los recursos necesarios para monitorearla.

Equipado con siete instrumentos, incluidos espectómetros infrarrojos y ultravioletas, una cámara telescópica de alta resolución y un detector de polvo espacial, durante su misión de seis meses, New Horizons colectará datos de la topografía de Plutón y su luna más grande, Charon, dándole a los astrónomos una mirada más cercana de sus superficies oscuras difíciles de observar desde la Tierra.

En julio de 2015, justo antes de concluir el estudio del cuerpo, la sonda intentará pasar lo más cerca de Plutón, que viaja en una órbita elíptica y tiene unos 2.300 km de diámetro -más pequeño que la luna de la Tierra. Esta cercanía, le permitirá a New Horizons pasar cerca de otros objetos en el Cinturón de Kuiper, un vasto anillo de escombros sobrantes del nacimiento del sistema solar, hace unos 4.600 millones de años.

El 25 de agosto de 2006, después de que lanzaran la sonda, Plutón fue bajado de categoría y dejó de ser un planeta. La Unión Astronómica Internacional cambió la definición de qué es un planeta y como resultado, el sistema solar pasó a tener sólo 8 planetas. Plutón, que había sido descubierto en 1930, pasó a ser considerado como un planeta enano.

Fuente: Clarín

Nuevo récord: 2014 ya es el año

más caliente de la historia

más caliente de la historia

Hasta ahora, 2014 es el año más caliente del que se tenga registro. La temperatura media del planeta en la superficie de la tierra y de los océanos fue la más alta registrada en el período de enero a octubre de 2014, informó la Organización Meteorológica Mundial (OMM). La agencia científica de Naciones Unidas señaló que el pasado mes de octubre fue el más caliente desde que empezaron los registros, en 1880, según los datos que ha recibido de la Agencia Nacional Oceánica y Atmosférica de Estados Unidos (NOAA).

De acuerdo con los análisis, las temperaturas combinadas de las superficies terrestre y oceánica en los primeros diez meses del año estuvieron 0,68 grados centígrados por encima de la media del siglo XX para este período, que fue de 14,1 grados centígrados. Sólo en el mes de octubre, la temperatura fue 0,74 grados superior a la media histórica de 14 grados centígrados. Este incremento se distribuyó de forma uniforme entre los hemisferios sur y norte. La medición ha sido también confirmada por el Centro del Clima de Tokio, la entidad regional de la OMM, y por datos de la NASA.

Se trató del 38° septiembre consecutivo que registra una temperatura mundial por encima del promedio del siglo XX, según informó la NOAA.

Fuente: Clarín

Crean un espejo que podría

sustituir al aire acondicionado

sustituir al aire acondicionado

Desde que los sistemas de aire acondicionado se popularizaron en el mundo, creció la preocupación por el enorme gasto de energía que estos equipos consumen. En la Argentina el problema se agravó en los últimos años por la falta de adecuación de la red eléctrica y los cortes de luz que se producen cuando sube la temperatura.

Muchos gobiernos iniciaron campañas para que la gente modere el uso del aire acondicionado, pero un grupo de científicos está diseñando una solución diferente: un espejo que podría enviar el calor que reciben los edificios al espacio, para así bajar la necesidad de refrigeración eléctrica.

Creado por científicos de la Universidad de Stanford, el espejo está diseñado de tal manera que refleja el 97% de la luz visible que cae sobre él. Además, actúa como un radiador térmico: cuando el espejo se calienta, libera el calor en una longitud de onda específica que pasa fácilmente a través de la atmósfera y sale al espacio.

El espejo está formado por varias capas de materiales delgados como una oblea. La primera es de plata reflectante. Sobre ella van capas alternadas de dióxido de silicio y óxido de hafnio. El espesor es de unos dos micrómetros, o dos milésimas de milímetro.

En las pruebas, el espejo tuvo un poder de refrigeración de 40 watts por metro cuadrado a temperatura ambiente. El costo de los espejos se estima en 20 a 70 dólares por metro cuadrado y el ahorro anual de energía en 100MW/h por año en un edificio de tres pisos.

Sin embargo, se descartó la idea de usarlos para frenar el calentamiento global. “El espacio de los techos de las casas y edificios representa sólo una pequeña parte de la superficie de la Tierra, así que no creemos que puedan ser una solución. Nuestro aporte es más bien reducir el consumo de electricidad”, planteó uno de los miembros del proyecto.

Fuente: Clarín

Crean un guante para trepar

por un vidrio como el hombre araña

por un vidrio como el hombre araña

Investigadores estadounidenses desarrollaron un nuevo dispositivo que le permite a un ser humano escalar sin problemas una pared vertical lisa. El material empleado en el dispositivo está inspirado en el gecko tokay, una lagartija oriunda de Asia que se desplaza sin inconvenientes por superficies verticales planas.

Lo que han logrado los científicos de la Universidad de Stanford fue replicar el sistema de adhesión de las pequeñas patas de estos reptiles a una escala mayor, sin perder efectividad; en otras palabras, crearon un guante de silicona del tamaño de una mano que funciona perfectamente para ascender por una pared de vidrio.

El guante utiliza las mismas fuerzas de atracción y repulsión entre las moléculas -conocidas con el nombre de fuerzas de Van der Waals - que usan aquellas lagartijas. Aunque estas fuerzas son muy débiles, el efecto se ve multiplicado por los millones de pelos microscópicos que cubren las patas de la lagartija asiática y que le permiten aferrarse con fuerza a las superficies.

Para poner los guantes a prueba, los investigadores diseñaron un arnés con dos guantes, conectados a dos apoyapiés. Este equipo le permitió a un hombre de 70 kilos trepar con éxito por una pared vertical de vidrio de 3,60 metros de altura. El hombre subió la pared cientos de veces y todos los intentos resultaron exitosos.

El adhesivo de los guantes no es pegajoso y puede utilizarse una y otra vez. Sirve para ascender por superficies lisas, incluyendo madera, vidrio, plástico y metal pintado. En superficies rugosas, este material no funciona con la misma eficiencia.

Los resultados de la investigación del equipo de Stanford fueron publicados en la revista Interface de la Royal Society.

Fuente: BBC Mundo

Fuente: Minuto Uno

Un estudiante argentino desarrolló zapatos vibradores para guiar a ciegos

Los zapatos para invidentes, llamados Duspavoni, fueron desarrollados por un estudiante de la Escuela Industrial N.º 4 de la ciudad de Río Gallego, y se presentaron en la Feria Nacional de Ciencias de Buenos Aires.

Los zapatos tienen tres sensores de ultrasonido colocados dentro de la suela en las áreas frontales, laterales y traseras. Los sensores emiten ondas de ultrasonido que rebotan en los objetos que los rodean y vuelven al sensor, que hace que el dispositivo vibre en función de la distancia y la posición de los objetos.

El dispositivo puede detectar diferentes tipos de materiales, personas y animales a un radio de 25 centímetros del usuario. Está equipado con baterías recargables que se pueden cargar mediante un cable USB conectado a un ordenador, o incluso con un cargador de teléfono móvil. El tiempo necesario para la recarga completa es de unas cinco horas, después de las cuales el dueño puede usar los zapatos durante tres o cuatro días.

Fuente: Argentina

Lanzan un nuevo gel para eliminar

las caries más rápido y sin dolor

las caries más rápido y sin dolor

Las caries son una de las patologías bucodentales más comunes que aparece en la infancia (según la OMS, entre 6 y 9 de cada diez niños la padecen) y continúa su asedio en la vida adulta. Científicos argentinos desarrollaron un gel enzimático que permite eliminar las caries sin dolor ni anestesia y en menos tiempo.

Se trata de un método de remoción atraumática de las caries que contempla los aspectos psicoemocionales del paciente y del profesional, afirman sus desarrolladores. El gel se coloca con una cucharita sobre la lesión y en tan sólo dos minutos ataca al tejido infectado, que es removido por el odontólogo en forma manual con movimientos pendulares y sin presión. Su principio activo es la papaína, la enzima de la papaya o mamón.

Fue estudiado en más de 2.000 pacientes (chicos de entre 6 y 17 años y adultos entre 35 y 70) con diferentes tipos de caries y avances de la infección. En el 80% de los casos no fue necesario aplicar anestesia y nueve de cada diez afirmaron no haber sentido dolor durante el tratamiento.

"Cuando hay una caries, una infección que tiene una multiplicidad de bacterias y microbios, uno tiene que tratarla. Se elimina esa infección con material rotatorio llamado turbina, se prepara una cavidad y después se la obtura. ¿Dónde interviene el nuevo gel? En lugar de pasar tanto tiempo el torno uno coloca el gel enzimático y en dos minutos produce una desorganización, una proteólisis del tejido cariado, infectado, lo neutraliza y lo desinfecta y evita en forma significativa los minutos de material rotatorio. Luego se hace la restauración como habitualmente lo hace el odontólogo”, explica Sergio Kohen, profesor adjunto de la Cátedra de Odontología Integral Adultos de la Universidad de Buenos Aires.

El gel comenzará a comercializarse el año que viene y cada jeringa (que rinde unas 15 aplicaciones) costará 490 pesos. Desde el laboratorio afirman que no añade gastos, sino que los recorta porque se evitan horas de trabajo y gastos en anestesia y otros materiales.

Fuente: Clarín

El detective del hielo antártico

Las regiones polares son remotas y están prácticamente deshabitadas, pero lo que allí ocurre tiene consecuencias para todo el planeta. Por ello, los científicos monitorizan desde hace décadas la evolución del espesor de las capas de hielo y los efectos del progresivo aumento de las temperaturas. Y es que, según advierten, el deshielo en el Ártico y en la Antártida se traducirá en un aumento del nivel del mar en otras zonas terrestres.

Estudiar la evolución del hielo en ambas regiones es una tarea compleja para la que habitualmente utilizan, sobre todo, imágenes recabadas por satélite o por aviones. Ahora, sin embargo, cuentan con un ágil robot submarino que les está ayudando a investigar la capa de hielo con mucha más precisión.

El vehículo robótico AUV (Autonomous Underwater Vehicle) es conocido como SeaBED (que significa fondo marino) y les ha permitido ya realizar los primeros mapas en tres dimensiones y alta resolución de la cobertura helada de la Antártida.

Un equipo internacional integrado por científicos de Reino Unido, EEUU y Australia presenta esta semana sus primeros mapas en 3D en la revista Nature Geoscience. Según señalan, este robot les ayudará a entender mejor los cambios que se están registrando en las capas de hielo debido al calentamiento global.

La topografía en 3D realizada desde la parte posterior de la capa de hielo ofrece nueva información sobre su estructura y los procesos que la originaron. Un aspecto que consideran clave para averiguar las diferencias entre las capas de hielo de la Antártida y el Ártico es que se trata de dos sistemas climáticos muy distintos.

De momento, SeaBED se ha usado en dos expediciones antárticas realizadas en 2010 y 2012, ambas durante la primavera austral. La primera se llevó a cabo con el buque RRS James Clark Ross de la British Antarctic Survey y la segunda, con el rompehielos australianoRSV Aurora Australis. En total, se mapearon tres lugares de la Península Antártica (Weddell, Bellinghausen y Wilkes Land), topografiando una superficie de 500.000 metros cuadrados. Según Williams, el plan es usar una segunda generación de robot, más avanzado, en el Ártico en 2015. "Hay más robots como éste, pero es el primero que se ha usado para hacer un mapa en 3D del hielo antártico", señala.

SeaBED mide dos metros de longitud y pesa unos 200 kilogramos. Es capaz de sumergirse a profundidades de entre 20 y 30 metros y su diseño le permite tener la estabilidad suficiente como para tomar imágenes a baja velocidad.

Lo que se ha descubierto en las áreas mapeadas es que el hielo estaba más deformado, como si estuviera formado por montones de trozos de hielo, y era más espeso de lo que se había visto en otros estudios.

Fuente: El Mundo

Aprueban la construcción de telescopio

óptico más grande del mundo

óptico más grande del mundo

El Observatorio Europeo Austral (ESO) confirmó la construcción en dos fases del telescopio óptico más grande del mundo en Chile, el European Extremely Large Telescope (E-ELT). La inversión en la primera fase ascenderá a mil millones de euros. El proyecto estará terminado en diez años, agregó el organismo.

"Este telescopio posibilitará tremendos descubrimientos científicos en temas como exoplanetas, la composición estelar de galaxias cercanas y el universo lejano", afirmó ESO en un comunicado.

El E-ELT tendrá un lente óptico de 39 metros y estará ubicado en la cima del Cerro Armazones en el desierto chileno de Atacama, a 20 kilómetros del Very Large Telescope de Cerro Paranal.

A diferencia de ALMA, el E-ELTes es un telescopio óptico, por lo que sólo puede mirar las zonas calientes del Universo, sin ingresar en los sectores del espacio y el tiempo cercanos al origen del cosmos.

Fuente: La Nación

Las PC que nadie quiere,

pero muchos necesitan

pero muchos necesitan

Los dispositivos digitales se actualizan año a año. Esa práctica implica también una gran cantidad de basura electrónica. El impacto de tales residuos, sumado a un proyecto de ley de basura electrónica que perdió estado parlamentario en 2012, hace que el problema se encuentre latente en nuestra sociedad.

Según datos de Greenpeace se estima que en 2011, 10 millones de celulares fueron descartados y más del 30% terminó directamente en rellenos o basurales.

Las computadoras también corren la misma suerte y, en tal caso, los datos de la Fundación Equidad hablan por sí solos: un 3% de cada computadora está compuesto por residuos contaminantes (plomo, mercurio, berilio, selenio, cadmio y cromo, entre otros). El resto de los materiales se divide en un 25% de componentes recuperables y un 72% de materiales reciclables (plásticos, metales ferrosos, aluminio, y cobre, oro, níquel, estaño). El problema aquí es que una computadora incluye en su estructura materiales que tardan entre 10 y 300 años en degradarse.

Por eso, muchas organizaciones trabajan para devolverles el brillo a viejas computadoras y reinsertarlas en sus funciones. Una es la mencionada Fundación Equidad, que cuenta con un taller de reciclado. Hasta el momento han donado computadoras a más de 1300 organizaciones y 800 instituciones educativas.

"Nuestra misión es proveer servicios y productos tecnológicos para promover la igualdad de oportunidades, la integración social y el cuidado ambiental. Para lograrlo hemos creado un taller de reciclado en el que, a partir de rezagos tecnológicos, se producen computadoras que son donadas a escuelas, comedores, hospitales y organizaciones sociales de todo el país. De este modo se cumple el doble objetivo de reducir la brecha digital y mitigar el impacto ambiental de los residuos electrónicos", plantearon desde la Fundación Equidad.

Sobre el proceso de reciclado, "una vez que las PC ingresan al taller, el proceso se divide en distintos eslabones. El primero es el desguace, donde separamos aquellos componentes que sirven y que pueden ser reutilizados. El resto es entregado a cooperativas de recicladores urbanos inscriptos en la Agencia de Protección Ambiental de la Ciudad de Buenos Aires”.

"Luego, los equipos pasan al sector de hardware, donde formateamos los discos, testeamos el resto de los componentes y realizamos el ensamble de la PC. En el área de software realizamos la instalación del sistema operativo, programas y antivirus. Las computadoras son entregadas con licencias legales, donadas por Microsoft, el antivirus NOD32 de ESET, garantía por 6 meses y un software que restringe el acceso a páginas de adultos. Luego, en control de calidad, comprobamos que no se hayan producido errores. En caso de que las carcasas de las CPU no esté en las mejores condiciones, las pintamos para que sean lo más parecidas posibles a una computadora nueva. Finalmente, colocamos cada computadora, junto a su mouse, teclado y cables de energía, en una caja lista para que sea retirada por los beneficiarios".

Podés donar tu computadora vieja aquí.

También existe un proyecto universitario de reciclado de computadoras llamado E-basura, el cual es un interesante emprendimiento forjado en la Universidad de La Plata. "La tarea consiste: primero en la recepción de solicitudes a través del portal (http://e-basura.linti.unlp.edu.ar) o por mail ( e-basura@linti.unlp.edu.ar ). Luego se coordina la fecha de entrega en función de los elementos ofrecidos en cuanto a cantidades y tipo. Posteriormente se pasa a la etapa de testeo inicial, para hacer el descarte de elementos y pruebas de funcionamiento. Después se procede a la reparación o separación de componentes y al armado de computadoras. A dichas PC se les instala el sistema operativo y las aplicaciones educativas desarrolladas en la Facultad de Informática con software libre basado en Linux, y para terminar se realiza un test de stress para asegurar la calidad. Concluida esta etapa se selecciona la entidad beneficiaria y se hace la donación", afirmó uno de los miembros del proyecto.

Fuente: La Nación

5G, una tecnología que se asemeja

a la ciencia ficción

a la ciencia ficción

Tras varios años de lanzamiento de la tecnología móvil de cuarta generación (4G), la primera que cuenta con estándares internacionales unificados, el sector ya piensa para 2020 en el 5G.

Más allá de los móviles con conexión a Internet, será una tecnología con velocidades y capacidades de gestión de tráfico de datos aún inimaginables, que podrían hacer posible desde interfaces y conversaciones con proyecciones holográficas en tres dimensiones a vivir entre millones de objetos cotidianos interconectados entre sí.

La telefonía 5G, que se espera que empiece a ser habitual en nuestras vidas entre 2020 y 2030, permitiría aplicaciones como las que ya se están desarrollando en laboratorio: interfaces basadas en proyecciones holográficas mediante láser, una realidad virtual con la que sería posible interactuar y mantener conversaciones en 3D.

Aparte de estas "interacciones entre humanos", la tecnología 5G también permitirá un grado sin precedentes de automatización de nuestra vida diaria, con interconexiones de máquina a máquina entre nuestros hogares, vehículos y objetos cotidianos, que podrán ser coordinados, o compartir datos entre sí, en nuestro beneficio.

Esto hará posible un futuro "Internet de las cosas" que permitirá eliminar la acción humana directa en todas estas operaciones, con incontables aplicaciones posibles, desde una gestión del tráfico urbano coordinada automáticamente por Internet a controles médicos sistemáticos del usuario.

Su conjunción con el creciente desarrollo de los sistemas de procesamiento y análisis de inmensas cantidades de datos en tiempo real (Big Data) y de la robótica, señaló, pueden dar un vuelco tecnológico al mundo en las próximas décadas que aún hoy parece ciencia-ficción.

Fuente: Minuto Uno

Fuente: La Nación

Un remedio que se probará en perros

podría alargar la vida de los humanos

podría alargar la vida de los humanos

Un equipo de investgadores estadounidenses realizarán nuevos experimentos en perros con las propiedades de la rapamicina. El objetivo final es utilizarla en la lucha contra el paso del tiempo en los seres humanos.

Se trata de la rapamicina, una medicina que es utilizada actualmente para prevenir el rechazo de los órganos trasplantados a una persona. Los especialistas llegaron a la conclusión de que el medicamento de carácter natural encontrado en el suelo de la Isla de Pascua, podría ayudar a prolongar la vida humana y mejorar la memoria durante la vejez.

Luego de haber llevado a cabo una serie de las pruebas, los médicos revelaron su nueva propiedad: el medicamento prolongó la vida en un 9% a los roedores masculinos y en un 14% a los femeninos. En base a este descubrimiento, los científicos pretenden ahora experimentar la droga en perros, lo que ayudará a pronosticar la posible acción del medicamento en los seres humanos.

Fuente: Minuto Uno

Las proteínas vinculadas al Alzhéimer

se propagan en el cerebro como una epidemia

se propagan en el cerebro como una epidemia

Investigadores del Instituto Neurológico de Montreal, liderados por un científico cubano, se han inspirado en un modelo de expansión de las epidemias para explicar cómo se extienden en el cerebro unas proteínas mal formadas que se asocian al envejecimiento y a enfermedades neurodegenerativas como el alzhéimer.

Una investigación publicada en la revista PLOS Computational Biology y liderada por un científico cubano, describe de forma matemática la propagación de las proteínas mal plegadas que se relacionan con el envejecimiento y las enfermedades neurodegenerativas, como el Alzhéimer. El modelo es similar a la propagación de enfermedades epidémicas en la sociedad, pero dentro del sistema nervioso.

Las proteínas beta amiloides y las proteínas tau llegan a alcanzar funciones tóxicas relevantes, entre las que se encuentra la afectación de las sinapsis neuronales y del equilibrio químico interno de las células cerebrales. Aunque no se conoce aún del todo cómo y por qué surgen, su presencia está muy vinculada a la progresión de la enfermedad, incluso décadas antes de que esta se manifieste. La acumulación de proteínas mal formadas en el cerebro ocurre porque no se limpian de forma eficiente. Este problema podría estar relacionado con las características genéticas individuales, aunque los investigadores no descartan la influencia de factores como el estilo de vida.

Si las proteínas mal plegadas no pueden eliminarse de una región cerebral, comienzan a reproducirse y a propagarse a regiones vecinas o anatómicamente conectadas. “En cierto sentido, y como demuestra nuestro estudio, siguen un patrón muy similar a la propagación de las enfermedades infecciosas en una población de individuos inicialmente sanos”, señala el investigador cubano. Igual que el foco infeccioso inicial se extiende a través de contactos sociales, estas proteínas lo hacen por contactos nerviosos.

Aunque las proteínas mal plegadas no son la única componente patológica en los procesos de neurodegeneración, el control de la mismas ayudaría a su vez a atenuar otras causas interrelacionadas.

Fuente: Agencia Sinc

Despegó la nave que llevaría

astronautas a Marte

astronautas a Marte

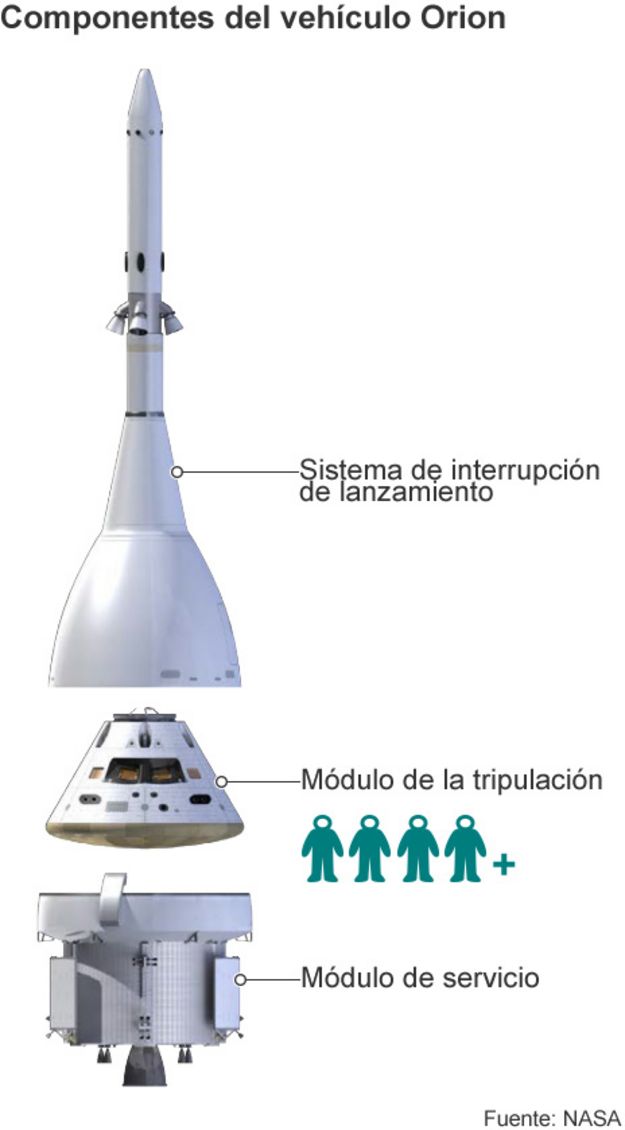

Luego de la postergación de por problemas técnicos con el cohete Delta IV, la NASA lanzó el viernes 5/12 apenas pasadas las nueve de la mañana la cápsula Orión. Se trata del primer vuelo de prueba no tripulado del vehículo diseñado para alcanzar nuevos destinos, en especial la llegada a Marte con astronautas.

Los datos recogidos en esta expedición se tendrán en cuenta para el diseño final del vehículo, con capacidad para transportar a cuatro astronautas al espacio exterior, antes de que se realice el primer vuelo tripulado previsto para 2021. Se calcula que para ese año, la NASA habrá gastado en estas misiones entre 19 y 22 mil millones de dólares.

En este vuelo de prueba, la cápsula circunvalará dos veces la Tierra a una distancia de 5.793 kilómetros del planeta, unas 15 veces más lejos que la distancia a la Estación Espacial Internacional (EEI), en un recorrido que durará unas cuatro horas.

La misión va a servir para analizar las capacidades de la nave en las funciones de entrada, descenso y aterrizaje y en particular del escudo térmico que protege a la cápsula de las altas temperaturas en su reingreso a la Tierra.

El Orión es el primer vehículo estadounidense con capacidad para transportar tripulación al espacio profundo desde la era de las misiones Apolo, que entre 1969 y 1972, realizaron numerosos vuelos a la Luna, hace ya más de cuarenta años.

Con Orion, la agencia espacial estadounidense tendrá de nuevo un vehículo propio para enviar al espacio a sus astronautas, ya que, desde que retiró en 2011 su flota de transbordadores. Orión llegará más lejos que cualquier otro vehículo tripulado hasta ahora y servirá también para medir la radiación a la que podrían estar expuestos los astronautas.

Fuente: Clarín

Fuente: BBC Mundo

Los teléfonos celulares y la ciencia de los datos

* Por Adrián Paenza

Para empezar, le pido que lea con atención el párrafo que figura acá abajo.

“En la década pasada, los teléfonos celulares han adquirido una fuerte popularidad en todo el mundo, cruzando todos los grupos demográficos. Son usados por hombres y mujeres indistintamente, cubriendo un amplio espectro de edades e independientemente de la riqueza del país en donde se encuentre el usuario. Estos teléfonos móviles se han transformado en uno de los mecanismos más importantes para estudiar la interacción social dentro de una población, convirtiéndose en una fuente increíble de información para analizar el comportamiento humano, la demografía humana y sus correlaciones. En particular, la información que uno recoge a través de las comunicaciones por vía de la telefonía celular están siendo usadas para elaborar análisis cuantitativos en la demografía de los usuarios, separándolos por edades, género, educación y poder adquisitivo”.

Este párrafo inicial debería ser lo suficientemente atractivo como para entender el salto de calidad que hemos dado en la última década. Para hacer estudios en el pasado era necesario mirar a “muestras” muy pequeñas, ya que el costo las transformaba en prohibitivas. La tentación a extrapolar sin tener suficientes datos nos hizo conjeturar cosas que terminaron siendo falsas. Pero aún más: la cantidad de datos que tenemos hoy es tan abrumadora, que si bien uno sabe que dentro de ese océano de información están escondidos mensajes, resulta muy difícil aún descifrarlos. Carlos Sarraute (1) lo puso en las siguientes palabras: “Uno sabe que hay una mina de oro escondida en alguna parte. Bien, pero ¿dónde buscar las pepitas?”.

Hacer las preguntas adecuadas, entender qué buscar y dónde buscar es una tarea a la que se dedica la Ciencia de los Datos. La “memoria” que se requiere usar es cada vez más grande, pero al mismo tiempo es cada vez más barata. Es por eso que en lugar de seleccionar, uno tolera “llevarse todo”: “Ya veremos cómo buscar lo que necesitamos”. Estoy seguro de que aquellas personas que tenemos el privilegio de usar “desde siempre” una computadora entendemos bien de qué se trata aun cuando uno las usa para tareas personales. ¿Cuántos de nosotros/ustedes tienen múltiples copias de un archivo que no necesita/mos? Antes, uno era muy precavido con lo que almacenaba, porque los armarios o cajas o cajones que teníamos disponibles eran muy pocos. Por eso los cuidábamos mucho. Hoy, ya no hace falta. Esa ventaja cuantitativa tiene un costo: cada vez cuesta más trabajo encontrar lo que uno busca.

Suponga que usted pudiera registrar todas las conversaciones telefónicas que se han hecho usando teléfonos celulares, todos los mensajes de texto, todas las fotos que se sacaron, todos los videos que se grabaron, toda la música que se escuchó, etc., etc.... ¿Y entonces? Aunque uno lo haga en forma anónima, aunque uno sea hipercuidadoso con la discreción que corresponde, aunque uno no quiera aprovecharse de las “fallas del sistema”, aun así.. ¿qué buscar? ¿Qué es lo importante? ¿Qué es lo que queremos aprender que no sabemos e intuimos que está escondido en esa montaña virtualmente “infinita” de información?

Como escribí más arriba habrá que educarse para saber qué preguntas hacer. Me surgen disparadores por todos lados. Se me mezcla la curiosidad que tenemos los humanos para descubrir cosas que ni sabíamos que nos interesaban hasta que las vimos por primera vez, con las dudas sobre lo “maligno” que esto podría resultar si esta montaña de datos quedara en “malas manos” (si es que no lo está ya). ¿Qué conclusiones estaremos dispuestos a tolerar? ¿Y si resulta que descubrimos cosas que no queremos saber? Así dicho, parece tonto: ¿cómo no vamos a querer saber? Bueno, podría haber gente que no quiera conocer determinadas cosas de su vida. Lo voy a poner en términos extremos para “tratar de tener razón”. Supongamos que usted pudiera averiguar que tiene una enfermedad que no conoce, silenciosa porque no tiene síntomas, pero que lo va a matar en un lapso muy breve. Exagero con el ejemplo en forma adrede para invitarla/lo a pensar. ¿Reaccionaríamos todos igual? ¿Todos querríamos saber? O mejor dicho, ¿todos querrían saber?

Las diferencias individuales que tenemos son fascinantes. Somos un mundo de individualidades tratando de coexistir en sociedad. Pero nuestras particularidades –inexorablemente– nos distinguen. Pero, como queda muy claro, me desvié de mi objetivo que era contar un trabajo científico que les valió a los autores (2), todos argentinos, el reconocimiento internacional que los/nos ubica en un lugar privilegiado en el mundo cuando se trata de hacer estudios de este tipo.

El trabajo se hizo con datos provistos por una compañía de teléfonos celulares en México. La idea era detectar algunos atributos de los usuarios (más específicamente), ser capaces de “deducir las edades de los clientes”. Me explico: la compañía les entregó datos de más de 90 millones de usuarios. Lo quiero escribir otra vez para que no crea que me equivoqué: más de noventa millones de usuarios. La base de datos usada consistió en las llamadas telefónicas que se efectuaron y también los SMS (mensajes de texto breves). Se recolectaron más de dos mil millones de llamados y otros dos mil millones de mensajes de texto. Se recopilaron en un plazo de tres meses y cada registro contenía la información detallada de los números de teléfono (pero anónimos en el sentido de que no se sabe quién es el usuario al que le corresponde ese número) y consistía en la información tanto de quien hacía la llamada como de quien la recibía. Se registraba también la duración de la llamada, el momento del día en el que se efectuaba y las antenas que fue utilizando el cliente a medida que se de- sarrollaba la acción.

Esta información tan detallada les permitió crear una red dinámica compleja con el agregado de la posibilidad de estudiar la movilidad, habida cuenta del cambio de antenas que se producía en el momento de la llamada.

Los autores separaron los datos para analizar un grupo de ellos y, luego, confrontar con el resto que tenían para saber si las inferencias que habían hecho eran correctas. En principio, dividieron a los usuarios –por edades– en cuatro categorías: menores de 25 años, entre 25 y 34, otra entre 34 y 49 y, la última, mayores de 50 años. La motivación que los llevó a hacer esta subdivisión que parece arbitraria fue debido a intereses particulares que tenía la compañía telefónica.

Las conclusiones más importantes fueron las siguientes:

a) Si bien la población mexicana tiene número de hombres y mujeres distribuidos en “mitades” (aproximadamente), esos porcentajes no se respetan entre los usuarios de telefonía celular. El 57 por ciento son hombres y el 43 por ciento, obviamente, mujeres. La diferencia es ciertamente muy notable. La desigualdad de género en cantidad también se manifiesta en el tiempo y duración de los llamados. El género masculino habla más tiempo, o por lo menos, está “más pegado al teléfono”.

b) Al distinguir las llamadas entrantes y salientes, también hay una asimetría. Los hombres hablan más tiempo cuando son ellos los que inician la llamada, pero son las mujeres las que hablan más tiempo cuando son ellas las que reciben la llamada.

c) Existe una fuerte homofilia respecto de la edad cuando uno estudia el grafo de las comunicaciones. ¿Qué quiere decir esto? Esencialmente significa que los humanos (al menos los que viven en México) tienen una tendencia desde el punto de vista estadístico a comunicarse con personas de edades similares. Es decir, hablan más con la gente de su propia edad que con cualquier otro grupo.

d) Sin embargo, el segundo “pico” de comunicaciones se da para una diferencia de edades de 25 años. Por ejemplo, un joven de 30 años habla más (en promedio) con otros jóvenes de 30 años o de edades cercanas, pero el segundo grupo relevante corresponde al de gente que tiene alrededor de 55 años. Si uno se permite pensar que cada 25 años se produce un salto generacional, es esperable que estas comunicaciones correspondan a llamados de hijos a sus padres (y al revés).

e) Otro dato interesante tiene que ver con cierta homofilia respecto del género. Es decir, los hombres hablan más entre ellos y lo mismo sucede con las mujeres. Me apuro a escribir una vez más (igual que los autores): todo esto es “en promedio”.

Con todos estos resultados, análisis posteriores les permitieron desarrollar un nuevo modelo, esta vez basado en la información de los vínculos de cada persona. ¿Qué quiere decir esto? Como todos los usuarios fueron divididos en cuatro categorías (por edades), si uno tomara una persona al azar, tendría un 25 por ciento de posibilidades de pertenecer a alguno de los grupos (la probabilidad de pertenecer a cada grupo es ¼). Sin embargo, usando el nuevo modelo, el algoritmo permite decidir a qué grupo pertenece esa persona con un 62 por ciento de posibilidades de estar en lo cierto. Como se advierte, es un resultado muy fuerte: uno puede inferir la edad de la persona en cuestión, en función de las personas con las que se comunica. Algo así como “dime con quién hablas y te diré qué edad tienes”.

Más allá de este estudio particular de los cientos que están haciendo mientras yo escribo esto y usted lo lee, decía, mi idea es mostrar cuál es la potencia de esta nueva ciencia conocida como “la ciencia de los datos”. Hasta hace nada más que diez años, todo esto habría sido imposible. La decodificación del genoma humano habría sido imposible. Toda la estructura en la que se basa la “minería de datos” habría sido imposible. Y la lista sigue.

Mientras tanto, uno sigue dejando huellas por todos lados, totalmente inconsciente de lo que hace y como si todo esto que está sucediendo les estuviera pasando “a los otros”. Bueno, lamento informar que no es así. Está aquí, acá, a su alrededor, “casi” en todas partes. No es ni bueno ni malo. Es. En la medida en que cada uno sepa que existe, sabrá qué es lo que hace, qué determinaciones toma. Pero lo que no podemos hacer, o mejor dicho, no deberíamos hacer, es ignorar lo que pasa. Mientras tanto, la vida sigue.

(1) Uno de los autores del trabajo del cual extraje el párrafo inicial, (2) Harnessing Mobile Phone Social Network Topology to Infer Users Demographic Attributes, por Jorge Brea, Javier Burroni, Martin Minnoni y Carlos Sarraute. O sea, en una traducción libre mía, algo así como “Tratando de ‘dominar’ la Topología de la Red Social provista por los teléfonos celulares, para tratar de inferir los atributos demográficos de los usuarios”.

Fuente: Página 12

No hay comentarios:

Publicar un comentario